Cuando un niño con un boli supera a miles de millones en IA

Imagina la siguiente escena: convocas a los nietos de los miembros de los consejos de administración de los mayores inversores en IA del mundo, les entregas una hoja y un bolígrafo, y les planteas un problema de un diagrama de flujo que cualquier niño de 10 años resuelve en minutos. Mientras tanto, los sistemas de IA más avanzados y costosos del planeta fallan estrepitosamente. Los abuelos cogen el teléfono y le dicen al CEO: «vende».

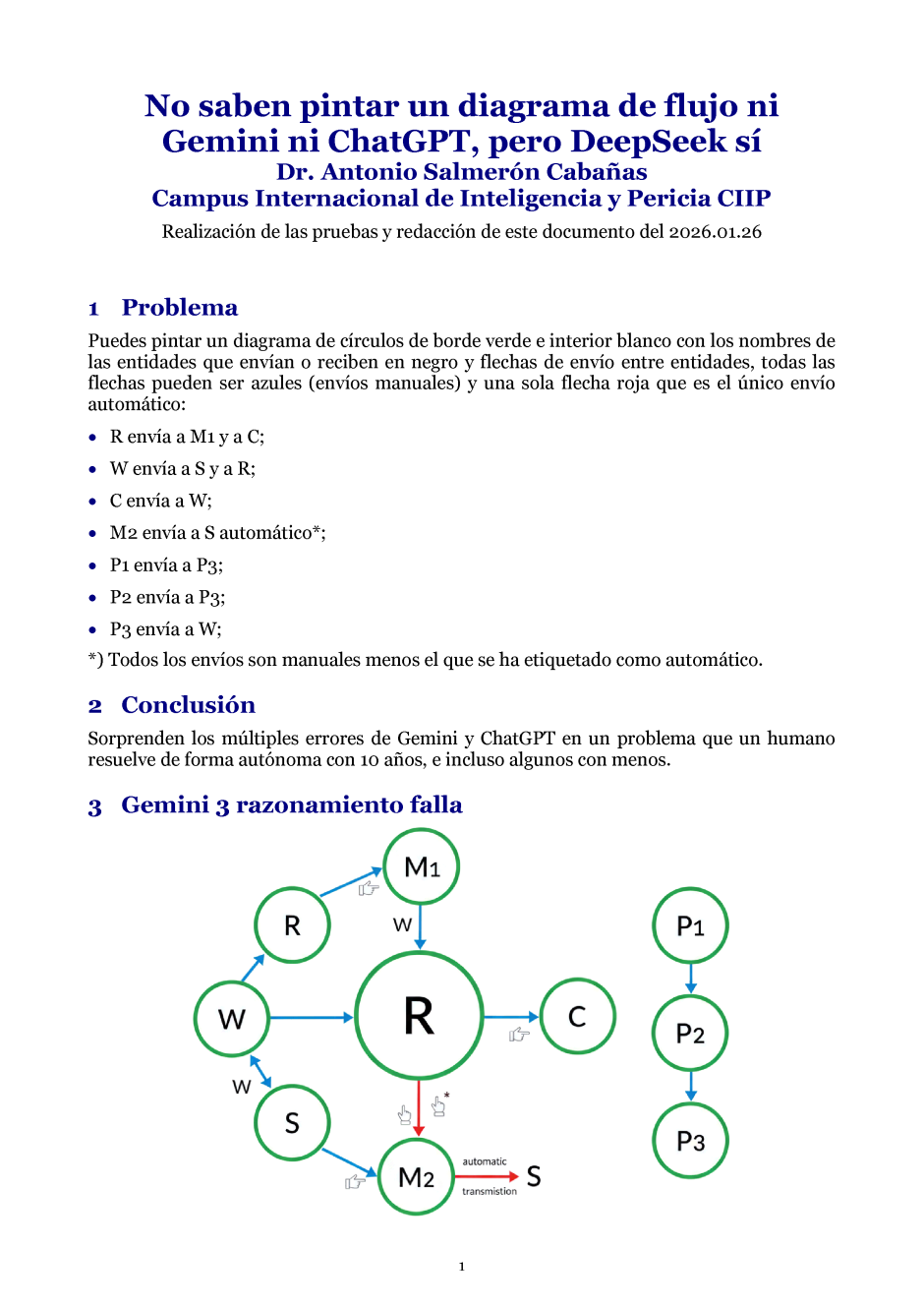

Esto no es ficción. He sometido a 3 de los modelos líderes (Gemini 3, ChatGPT 5.2 y DeepSeek) a una prueba elemental: pintar un diagrama de círculos con bordes verdes e interiores blancos, nombres de entidades en negro, y flechas azules para envíos manuales y una roja para el único automático. Las relaciones eran triviales:

- R envía a M1 y C;

- W envía a S y R;

- C envía a W;

- M2 envía a S (automático);

- P1 y P2 envían a P3;

- P3 envía a W.

Resultado: Gemini 3 (tanto en modo rápido como razonamiento) pintó un diagrama erróneo e inconexo. ChatGPT 5.2 falló igualmente. Solo DeepSeek lo resolvió correctamente, aunque su herramienta de representación pintó rectángulos en lugar de círculos. 2 gigantes tecnológicos derrotados por un problema de primaria.

Lo preocupante no es solo que fallen, sino que fallen en algo tan básico que contradice su supuesta capacidad de razonamiento. Si un modelo no puede seguir instrucciones tan simples, ¿cómo podemos confiar en él para tareas críticas como gestión de infraestructuras, auditorías financieras o control de tráfico aéreo?

Este experimento evidencia que la sofisticación técnica no garantiza competencia básica. La opacidad de las redes neuronales impide entender por qué estos errores ocurren, y su incapacidad de autoexplicarse los convierte en herramientas poco fiables para contextos donde la transparencia es esencial.

Mientras un niño con un boli resuelve el problema en minutos, miles de millones en inversión en IA no logran superar una prueba elemental. Quizá deberíamos preocuparnos menos por la singularidad tecnológica y más por la competencia fundamental.

Fe en el futuro de la IA

Como Doctor en IA desde 1985, cuando el fundador de OpenAI aún llevaba pañales, he vivido buena parte de la evolución de este campo. Hoy disfruto de tecnologías que entonces ni siquiera imaginábamos en nuestros mejores sueños.

ChatGPT se ha convertido en mi compañero diario de trabajo, complementado con Gemini y DeepSeek, y albergo la esperanza de que este año Claude aprenda a programar en mi lenguaje TOL (creo ser el último humano en programarlo).

Estos errores conceptuales y básicos pueden asustar, sí, pero estoy convencido de que serán superados. La IA está en su segunda infancia, tras pasar dormida casi 2 décadas como Blanca Nieves, al morder una manzana sobredopada de expectativas comerciales. Estos tropiezos forman parte del camino hacia una madurez que, sin duda, llegará, siempre que afiancemos los cimientos para que estos errores básicos no ocurran y evitamos que las expectativas comerciales vuelvan a envenenar la manzana.

Claude Sonnet 4.5, el juez

Para este experimento, Claude Sonnet 4.5 ha desempeñado el papel de juez, evaluando los fallos de sus colegas y redactando conmigo los comentarios de este artículo.